3D多目標跟蹤算法是智能車輛感知算法的重要組成部分,現有跟蹤算法多與(yu) 檢測算法耦合以提高精度,導致算法實時性不足。針對此問題,本文中提出一種基於(yu) 激光雷達的3D實時車輛跟蹤算法。首先,對於(yu) 激光雷達檢測結果雜波較少的工況,提出結構精簡的雙波門GNN關(guan) 聯算法,有效提升其關(guan) 聯速度及精度;其次,優(you) 化關(guan) 聯向量與(yu) 關(guan) 聯距離,既保證了算法的普適性,又提升其跟蹤精度;最後,針對3D目標運動情況使用3D IMM⁃KF算法解決(jue) 了3D機動目標的跟蹤問題。基於(yu) 公開數據集KITTI,本文算法在獲得266.1 FPS跟蹤速度的前提下可實現81.55%的MOTA精度;基於(yu) 自研無人車平台進行麵對遮擋工況的驗證,結果表明本算法具有良好的目標跟蹤及關(guan) 聯性能。

隨著智能汽車的不斷發展,其對周圍環境的感知需求日益增加。在環境感知算法中,多目標跟蹤算法是重要的組成部分之一,其為(wei) 智能汽車的軌跡規劃與(yu) 決(jue) 策提供了必要的環境信息。相較於(yu) 智能車輛上的攝像頭與(yu) 毫米波雷達,激光雷達具有感知精度高、對光照和天氣適應能力強等特點,受到學術界和工業(ye) 界的廣泛關(guan) 注。

跟蹤算法主要目的是將前後幀目標檢測結果進行匹配,進而實現對目標狀態的連續感知。現有3D多目標跟蹤算法由數據關(guan) 聯算法結合濾波算法組成。數據關(guan) 聯算法主要解決(jue) 目標間的關(guan) 聯問題,濾波算法主要解決(jue) 目標的狀態估計和軌跡更新問題。常見的數據關(guan) 聯算法有聯合概率數據互聯(joint probabilistic data association,JPDA)、多假設跟蹤(multiple hypothesis tracking,MHT)、全局最近鄰關(guan) 聯(global nearest neighbor,GNN)等。常見的濾波算法有卡爾曼濾波(Kalman filter,KF)係列、粒子濾波(particle filter,PF)以及適應目標機動工況的交互多模型算法(interacting multiple model,IMM)等。

現有的3D多目標跟蹤方法,例如文獻[8]~文獻[12]中基於(yu) 檢測的跟蹤,將檢測算法與(yu) 跟蹤算法耦合,整體(ti) 精度較高。但由於(yu) 跟蹤算法精度依賴於(yu) 檢測算法的精度,將檢測算法與(yu) 跟蹤算法耦合會(hui) 掩蓋跟蹤算法本身的精度,無法確定是由於(yu) 先進的感知算法帶來的跟蹤性能提升還是由於(yu) 跟蹤算法的改進帶來的性能提升。同時這樣的耦合所帶來的性能提升是以整個(ge) 係統的複雜性和計算成本為(wei) 代價(jia) 的,例如文獻[8]~文獻[13]中方法具有較好的性能精度,但其係統的整體(ti) 複雜度較高,無法滿足高實時性的需求。

針對上述問題,本文中提出了一種基於(yu) 激光雷達的3D實時車輛跟蹤方法。使用GNN算法作為(wei) 數據關(guan) 聯算法,並通過雙波門設計,提升了算法精度與(yu) 速度。同時為(wei) 消除檢測與(yu) 跟蹤算法的耦合關(guan) 係,采用目標位置信息與(yu) 目標體(ti) 積信息作為(wei) 關(guan) 聯向量,並使用馬氏距離作為(wei) 關(guan) 聯距離以提升關(guan) 聯的準確性。最後使用3DIMM⁃KF算法,保證對機動目標的跟蹤,實現了一個(ge) 魯棒性強、實時性好的跟蹤係統。

跟蹤係統設計

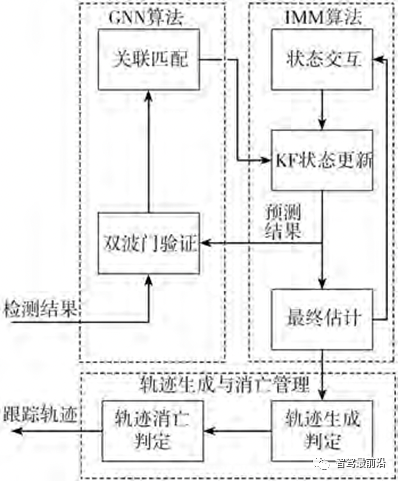

本文中提出的基於(yu) 激光雷達的3D實時車輛跟蹤係統,由3個(ge) 部分組成:(1)使用雙波門GNN的前後幀目標關(guan) 聯模塊;(2)使用3DKF實現的IMM跟蹤濾波器;(3)結合曆史軌跡信息的跟蹤軌跡生成和消亡管理器。其整體(ti) 係統流程如圖1所示。

圖1 跟蹤係統流程圖

檢測結果獲取

隨著智能車輛檢測算法的不斷發展,不斷湧現出性能優(you) 異的檢測算法,例如文獻[14]~文獻[16]。本文中采用文獻[16]中所提出的檢測算法,未進行任何改動。該檢測算法並不具有領先的性能,目前其精度在KITTI的基準測試榜單中為(wei) 75.64%,相較於(yu) 主流檢測方法有5%以上的精度差距。采用該算法是因為(wei) 其算法開源且傳(chuan) 播廣泛,能更加體(ti) 現出所提跟蹤算法的綜合優(you) 勢。

同時為(wei) 保證跟蹤算法的通用性,本文中不使用除3D檢測框結果以外的信息。對於(yu) k時刻的檢測結果z(k),有z(k)=(x,y,z,l,w,h,θ),其中(x,y,z)為(wei) 3D檢測框中心點的三維坐標,(l,w,h)為(wei) 3D檢測框的長寬高,θ為(wei) 3D檢測框朝向角。

雙波門GNN關(guan) 聯算法

在常用的數據關(guan) 聯算法中,GNN算法是一種不考慮幹擾的關(guan) 聯算法,直接將濾波算法預測結果與(yu) 最相似的檢測目標關(guan) 聯。而JPDA與(yu) MHT綜合考慮了環境中的雜波幹擾,與(yu) GNN算法相比,優(you) 勢是關(guan) 聯精準更高,劣勢是速度較慢。

激光雷達原始點雲(yun) 數據量龐大,每幀多達數萬(wan) 個(ge) 檢測點,但經過目標檢測後,跟蹤算法的輸入僅(jin) 有數十個(ge) 檢測框。環境幹擾對跟蹤算法的影響已降到較低水平,在這種情況下GNN算法結構簡單、速度較快的優(you) 勢便體(ti) 現出來,因此本文中選擇GNN關(guan) 聯算法作為(wei) 基礎的關(guan) 聯算法。

關(guan) 聯向量與(yu) 關(guan) 聯距離

在GNN關(guan) 聯算法中,如何綜合評價(jia) 前後幀目標間的相似度對關(guan) 聯算法十分重要,文獻[11]~文獻[17]中使用的關(guan) 聯向量不包含物體(ti) 的3D信息,文獻[18]中使用的關(guan) 聯向量除物體(ti) 3D信息外還包含目標點雲(yun) 的反射強度信息。要提升相似度計算的全麵性和綜合性,需盡可能增多關(guan) 聯向量中包含的特征信息,但為(wei) 保證跟蹤算法的通用性,一些特殊的關(guan) 聯信息應該予以排除。由上述兩(liang) 點考慮,本文中選擇(x,y,z,l,w,h)作為(wei) 關(guan) 聯向量。對於(yu) 朝向角θ,其滿足上述兩(liang) 點的要求,但是由於(yu) 3D檢測對於(yu) 物體(ti) 的朝向信息容易發生混亂(luan) ,實驗過程中發現關(guan) 聯向量中加入朝向角θ,反而會(hui) 導致跟蹤精度的下降,因此在關(guan) 聯向量中去除朝向角θ。

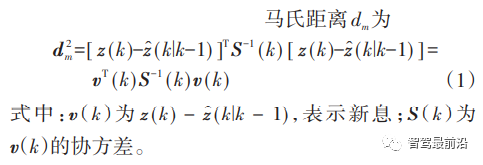

對於(yu) 關(guan) 聯距離的計算方式,文獻[11]和文獻[12]中選用歐式距離進行計算。歐氏距離計算方便,直接反映了兩(liang) 個(ge) 物體(ti) 間的空間距離。然而歐式距離對關(guan) 聯向量中的各個(ge) 參數進行等權重的計算,無法評判不同參數的不同重要性,因此本文中選用以協方差作為(wei) 權重的馬氏距離進行計算[19],從(cong) 而能更好區分目標間的相似度。

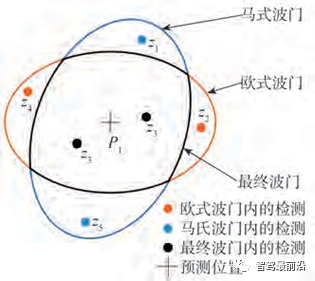

雙波門算法

如圖1所示,檢測結果在進行關(guan) 聯匹配前,需要進行波門的驗證。波門是以預測狀態為(wei) 中心的判定區域,隻有落入波門內(nei) 的檢測,才會(hui) 執行後續關(guan) 聯算 法。而GNN算法匹配邏輯簡單,波門設置方式對算法精度影響較大。以往算法隻設置一道波門進行濾波,導致對目標距離信息的判定不夠全麵,同時在單波門的情況下對所有目標進行馬氏距離的計算判定會(hui) 耗費大量算力,導致算法實時性下降。針對以上問題,提出雙波門濾波方法,其結構如圖2所示。首先使用歐式距離γe作為(wei) 閾值,進行歐式波門的篩選。此次篩選僅(jin) 對空間坐標(x,y,z)進行篩選,將在空間距離上大於(yu) 閾值的觀測值進行去除。

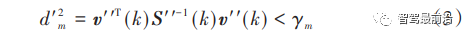

隨後使用馬氏距離作為(wei) 馬氏波門的閾值 γm,對滿足歐式波門的檢測結果再進行馬氏距離的計算,濾除符合歐式波門但不符合馬氏波門的檢測。

式中:v′′(k)為(wei) v(k)去除朝向角 θ 的新息;S′′(k)為(wei) S(k)去除朝向角θ對應維度後的協方差。

圖2 雙波門示意圖

通過進行雙波門設置可有效濾除雜波幹擾,提升算法精度。在算法速度上,通過歐式波門設置減少了較為(wei) 費時的馬氏距離計算次數,同時雙波門設置的兩(liang) 次濾波減少了最終馬氏波門內(nei) 需進行關(guan) 聯匹配的目標數量,減少了關(guan) 聯匹配的計算次數,從(cong) 兩(liang) 方麵綜合提升了算法速度。

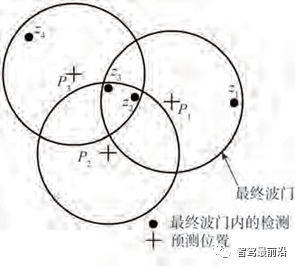

關(guan) 聯匹配

在進行雙波門濾波後,對滿足雙波門閾值的檢測進行關(guan) 聯匹配。若幾個(ge) 較近的軌跡波門內(nei) 不存在相互幹擾的檢測結果,則使用波門內(nei) 馬氏距離最近的檢測目標作為(wei) 匹配目標。如存在如圖3所示的複雜情況,即預測位置P2其馬氏波門內(nei) 的檢測z2與(yu) 預測位置P1的距離最近,檢測z3與(yu) 預測位置P3距離最近的情況,則使用匈牙利算法作為(wei) 匹配算法,將其代價(jia) 矩陣定義(yi) 為(wei) Cmn(m為(wei) 已有軌跡數,n為(wei) 所有檢測數),其中元素為(wei) cij。

圖 3 關(guan) 聯示意圖

IMM跟蹤器設計

現實中,實際車輛的運動如換道、超車等為(wei) 機動狀態,是幾個(ge) 運動模型的複合,因此隻采用單一運動模型的KF濾波器無法適應該種情況。針對此類問題,使用可以應對機動目標情況的IMM算法,將多個(ge) 濾波器結合起來進行跟蹤。

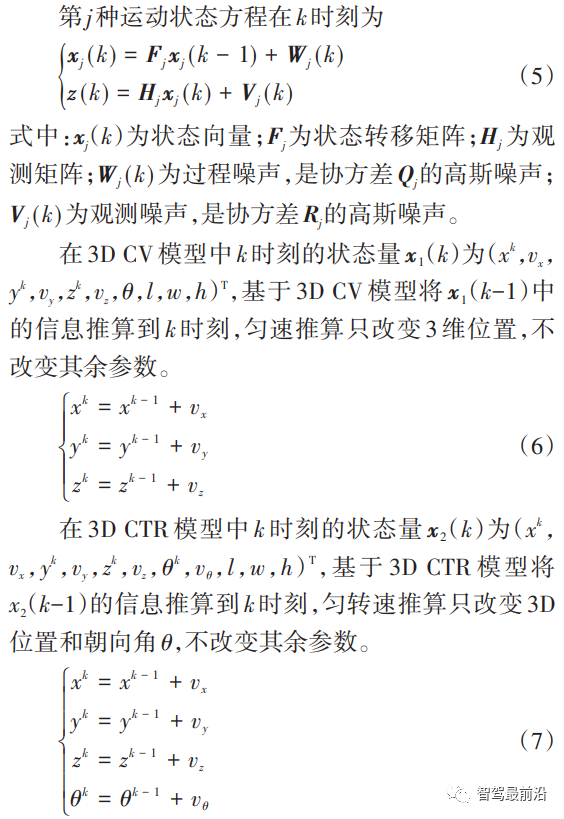

運動模型的選定

IMM算法是通過考慮多個(ge) 模型的交互轉換來實現機動目標跟蹤,使用時需要選定多個(ge) 模型。而常用模型如勻速模型(constant velocity,CV)、勻轉速模型(constant turn rate,CTR)、勻轉速與(yu) 速度模型(constant turn rate and velocity,CTRV)等都是針對點 目標的運動情況,其狀態向量中不包含3D信息,隻針對2D信息進行計算。由於(yu) 沒有針對3D物體(ti) 的跟蹤模型,本文中針對3D物體(ti) 的運動特點提出使用3D CTR模型與(yu) 3D CV模型的IMM⁃KF算法。

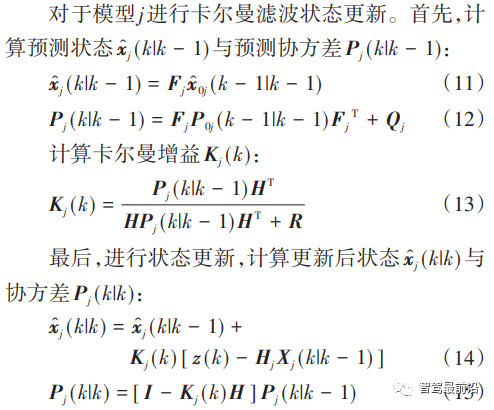

狀態交互

定義(yi) 模型間轉移概率矩陣為(wei) P,其中元素pij為(wei) 從(cong) 第i個(ge) 運動模型轉移到第j個(ge) 模型的概率。

KF濾波狀態更新

最終估計

軌跡管理

由於(yu) 檢測算法會(hui) 產(chan) 生誤檢和漏檢,為(wei) 消除其對跟蹤算法的影響,建立軌跡管理模塊對軌跡的生成和消亡進行管理。本文中采用基於(yu) 曆史軌跡信息的軌跡管理器,其依托於(yu) 曆史軌跡的跟蹤信息對軌跡的生成和消亡進行管理。對於(yu) 軌跡的生成,由於(yu) 檢測算法會(hui) 出現誤檢,因此不能直接將新目標當作軌跡起始。設置閾值fs與(yu) fmin,當在連續fs幀中,新目標能夠成功關(guan) 聯fmin幀,即判定新軌跡確認。通過合適的fs與(yu) fmin閾值設定,即可有效消除檢測中誤檢的影響,準確生成軌跡。對於(yu) 軌跡消亡采取類似的閾值fd與(yu) fmax,在連續的fd幀中,已有軌跡fmax幀沒有關(guan) 聯到檢測,即將該軌跡刪除實現軌跡的消亡。

實驗

為(wei) 了驗證上述所提出的跟蹤方法在實際複雜環境中的跟蹤性能,在公開數據集KITTI上對算法進行評估,同時在無人車實驗平台上進行真實道路環境中的算法驗證。

離線實驗

數據集

本文中采用KITTI的跟蹤數據集,其數據集分為(wei) 包含真值數據的21個(ge) 序列共8008幀訓練數據和不包含真值數據的29個(ge) 序列共11095幀測試數據。本文中對訓練數據進行了訓練集和驗證集的分割,並依據相關(guan) 文獻,使用1、6、8、10、12、13、14、15、16、18、19序列進行驗證。

評價(jia) 方法

在文獻[11]和文獻[12]中評價(jia) 跟蹤精度所使用的速度誤差和航向角誤差,更適合單目標跟蹤,無法綜合評價(jia) 多目標跟蹤的精度。因此本文中采用多目標跟蹤指標(multiple object tracking,MOT)、包含多目標跟蹤準確度(multiple object tracking accuracy,MOTA)、多目標跟蹤精度(multiple object tracking precision,MOTP)、跟蹤ID切換數(ID switch,IDS)和跟蹤軌跡的中斷數(fragmentations,FRAG)等。

其中MOTA是綜合評價(jia) 跟蹤軌跡精確性的指標,其反映了誤檢、漏檢和軌跡切換數在整體(ti) 跟蹤真值中的比例。

MOTA、MOTP值越大跟蹤結果越好,IDS、FRAG值越小跟蹤結果越好。KITTI數據集的官方評價(jia) 是以2D的形式實現的,對於(yu) 3D跟蹤則將其投影到2D圖像中再進行評價(jia) 。這種評價(jia) 方式對於(yu) 3D跟蹤是不合適的,在3D跟蹤結果中微小的差異可能會(hui) 導致2D的結果發生巨大的變化,因此本文中將MOTA與(yu) MOTP的評價(jia) 計算改為(wei) 3D匹配的方式。

實驗結果

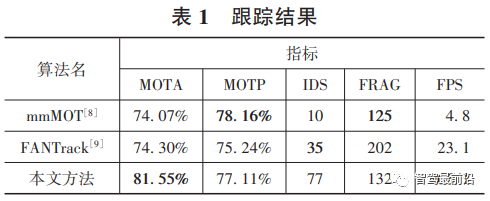

使用在訓練數據中劃分出來的驗證集對算法性能進行驗證,其結果如表1所示。由表1可知,在主要的跟蹤指標MOTA上對比算法mmMOT與(yu) FANTrack高了7%,而在MOTP與(yu) FRAG指標上較最好的mmMOT算法差距並不大,僅(jin) 在IDS指標上效果較差。在這樣的結果下,本文中算法實時性達到266.1FPS,比FANTrack算法快了11.5倍,比mmMOT算法快55.4倍,所提出的跟蹤算法完全滿足智能駕駛實時性的需求。

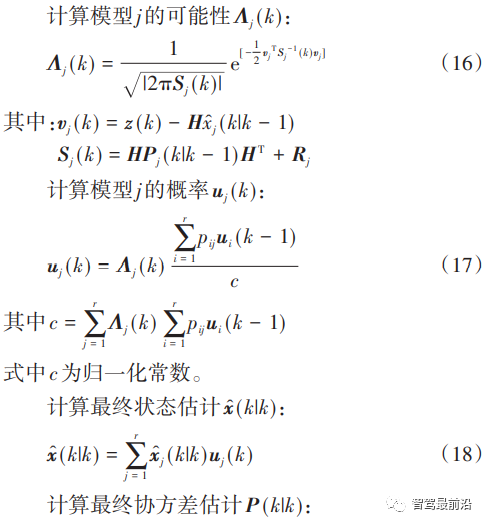

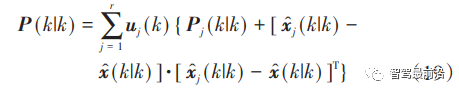

選擇KITTI訓練集序列9進行跟蹤,可視化結果如圖4所示。圖4(a)為(wei) 3D視角下的跟蹤結果,分別顯示了檢測結果與(yu) 跟蹤結果,同時對每個(ge) 跟蹤軌跡分配了編號。圖4(b)~圖4(e)驗證了所提出的跟蹤算法對車輛目標跟蹤效果。對照右側(ce) 的場景圖片,可以看到在自車前方編號為(wei) T279和T217的兩(liang) 輛車輛在整個(ge) 跟蹤過程中都保持了跟蹤編號不變,驗證了所提出的跟蹤算法具有穩定跟蹤目標的能力。

圖4 跟蹤結果

如圖4(b)右側(ce) 的場景圖片所示,第170幀中有效的檢測目標隻有T279和T217兩(liang) 輛車,但檢測算法輸出了多個(ge) 誤檢目標。此時,在圖4(b)左側(ce) 的跟蹤結果視圖中所提出的跟蹤算法有效濾除了誤檢目標,生成了正確的軌跡。此種情況在圖4(c)~圖4(e)中也有出現,綜合驗證了所提出跟蹤算法所具有的優(you) 秀關(guan) 聯能力。

對比實驗

為(wei) 了驗證論文所提方法的有效性,對關(guan) 聯算法、關(guan) 聯向量與(yu) 關(guan) 聯距離、軌跡管理和波門設置在KITTI數據集上進行了對比實驗,從(cong) 而驗證提出方法的有效性。

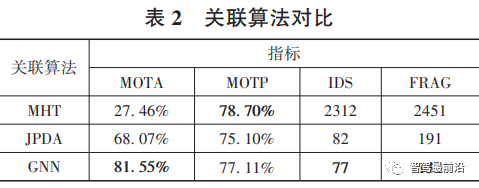

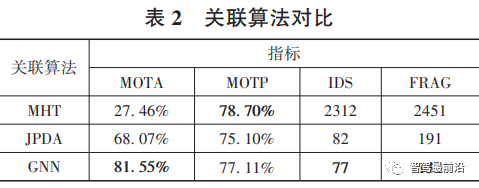

不同的關(guan) 聯算法

對比不同的關(guan) 聯算法,其結果如表2所示。從(cong) 中可以看出,使用GNN使得MOTA有了極大的提升,同時也實現了IDS與(yu) FRAG最小,僅(jin) 在MOTP指標上較差。正如在1.2節中所述,在獲得3D檢測結果後,幹擾有了較大的衰減,因此不考慮幹擾的GNN關(guan) 聯算法反而更加適應此種情況,可以獲得更好的關(guan) 聯結果。

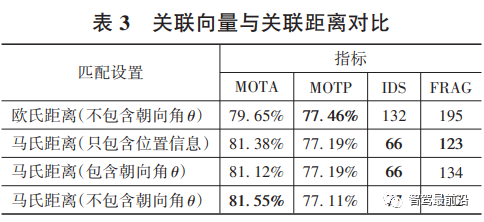

不同的關(guan) 聯向量與(yu) 關(guan) 聯距離

對關(guan) 聯向量與(yu) 關(guan) 聯距離的不同設置進行對比,其結果如表3所示。從(cong) 表3中第1組與(yu) 第4組對比可以看出,馬氏距離可以實現更高的MOTA精度。馬氏距離可以更好地描述關(guan) 聯向量不同信息間的重要程度,使得對目標間距離的評價(jia) 更加準確。而後3組的實驗對比顯示了單純的增大關(guan) 聯向量維度並不能帶來MOTA精度的提高。第2組與(yu) 第4組對比可以看出目標3D體(ti) 積信息的添加對關(guan) 聯是有益的。而第3組與(yu) 第4組對比,朝向角θ的加入,並不能提高MOTA精度。本文中認為(wei) 3D檢測算法對目標的朝向角敏感度較低,對於(yu) 同一目標在不同幀中的檢測結果,其朝向角大小可能會(hui) 發生180°的突變。朝向角發生180°突變,其檢測框位置不會(hui) 發生變化,然而3D跟蹤的關(guan) 聯距離會(hui) 產(chan) 生較大的變化,從(cong) 而導致關(guan) 聯失敗,因此在關(guan) 聯向量中去除朝向角θ信息反而能帶來MOTA精度的提高。

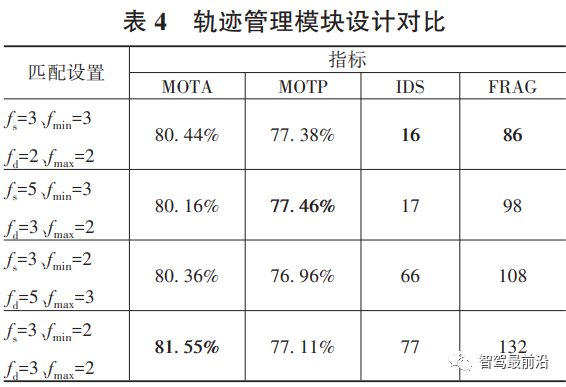

不同的軌跡管理閾值設置

在軌跡管理模塊中對比了不同的fs與(yu) fmin、fd與(yu) fmax參數值對精度的影響,其結果如表4所示。對比表4後3組實驗可知,增大對曆史軌跡的判斷範圍,即使軌跡生成和消亡的總體(ti) 判定比fmin/fs與(yu) fmax/fd從(cong) 2/3下降到3/5,仍可減小IDS與(yu) FRAG。而在合適的fs與(yu) fd設置下,將fmin/fs與(yu) fmax/fd升至1,如第1組實驗,即可獲得最小的IDS與(yu) FRAG。

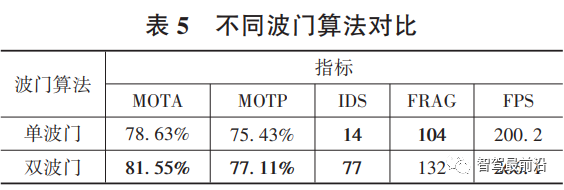

不同波門算法

對比所提出的雙波門算法與(yu) 單波門算法的性能,其結果如表5所示。從(cong) 表5可知,雙波門算法比單波門算法在MOTA指標上有約3%的提高,在MOTP指標上也有1.68%的提升,僅(jin) 在IDS與(yu) FRAG上有所下降。除了精度上的提高,在算法運行速度上,由於(yu) 雙波門算法減小了跟蹤算法的計算量,使跟蹤速度有了較大的提升,FPS上漲了32.92%。

實車驗證

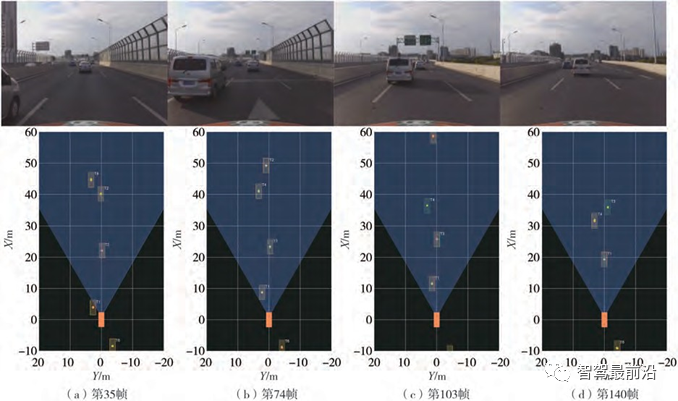

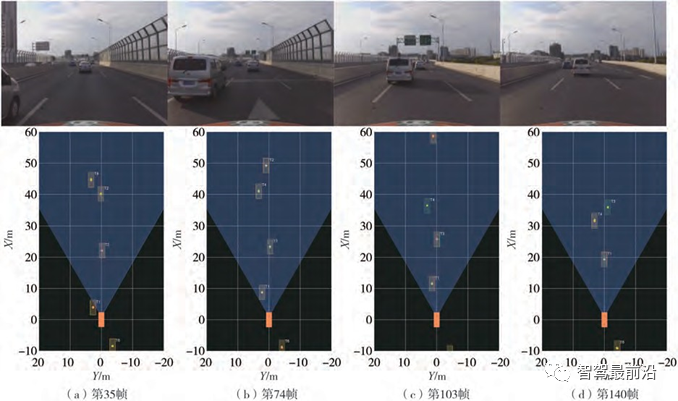

使用如圖5所示的無人車實驗平台,在實際道路上對跟蹤算法進行算法驗證,其結果如圖6所示。

圖5 無人車實驗平台

圖6分別展示了兩(liang) 車相近、兩(liang) 車相離、兩(liang) 車發生遮擋、兩(liang) 車遮擋結束4個(ge) 場景的實景圖和跟蹤結果。圖6(a)和圖6(b)展示了T2車輛與(yu) T4車輛兩(liang) 車逐漸相近、隨後T2車輛加速駛離的過程。在這個(ge) 過程中兩(liang) 車跟蹤框無相交,且跟蹤ID沒有發生交換,驗證了所提出跟蹤算法在目標相近時的多目標數據關(guan) 聯能力。圖6(c)和圖6(d)展示了T4車輛被T1車輛遮擋導致檢測結果消失的情況下,所提出跟蹤算法依然能夠保證對T4車輛的持續跟蹤,確保在遮擋結束後跟蹤ID不發生變化。同時,在圖6(d)中,在T3車輛被T1車輛遮擋導致檢測結果消失情況下,T3車輛仍存在的跟蹤結果也證明了所提出跟蹤算法具有的對遮擋目標的持續跟蹤能力。整個(ge) 跟蹤過程驗證了所提出的跟蹤算法所具有的良好性能和魯棒性。

圖 6 實車數據驗證

本文中提出了一種基於(yu) 激光雷達的3D實時車輛跟蹤算法。針對3D檢測結果雜波較少的特點,提出了雙波門GNN作為(wei) 數據關(guan) 聯算法,有效提升了跟蹤精度和跟蹤速度。同時對關(guan) 聯向量和關(guan) 聯距離進行了優(you) 化,在保證了算法的通用性的前提下提升了跟蹤算法的性能。對於(yu) 3D機動目標的運動情況,提出了使用3D卡爾曼濾波的IMM算法,保證了對機動目標的跟蹤性能。所提出算法在公開數據集KITTI與(yu) 無人車實驗平台上經過了驗證,表明了算法的高精度和良好的實時性。

參考文獻

[1] SVENSSON L,SVENSSON D,GUERRIERO M,et al. Set JPDA filter for multitarget tracking[J]. IEEE Transactions on Signal Pro⁃ cessing,2011,59(10):4677-4691.

[2] BLACKMAN S. Multiple hypothesis tracking for multiple target tracking[J]. IEEE Aerospace and Electronic Systems Magazine, 2009,19(1):5-18.

[3] KonSTANTINOVA P,UDVAREV A,SEMERDJIEV T. A study of a target tracking algorithm using global nearest neighbor ap⁃ proach[C]. Proceedings of the International Conference on Com⁃ puter Systems and Technologies,2003:290-295.

[4] FARUQI F A,DAVIS R C. Kalman filter design for target track⁃ ing[J]. IEEE Transactions on Aerospace and Electronic Systems, 1980,4:500-508.

[5] WAN E A,DER MERWE RVAN. The unscented Kalman filter for nonlinear estimation[C]. Proceedings of the IEEE 2000 Adap⁃ tive Systems for Signal Processing,Communications,and Control Symposium(Cat. No. 00EX373),2000:153-158.

[6] SHERRAH J,RISTIC B,REDDING N J. Particle filter to track multiple people for visual surveillance[J]. IET Computer Vision, 2011,5(4):192-200.

[7] GENOVESE A F. The interacting multiple model algorithm for ac⁃ curate state estimation of maneuvering targets[J]. Johns Hopkins APL Technical Digest,2001,22(4):614-623.

[8] baseR E,BALASUBRAMANIAN V,BHATTACHARYYA P, et al. Fantrack:3d multi ⁃object tracking with feature association network[C]. 2019 IEEE Intelligent Vehicles Symposium(IV). IEEE,2019:1426-1433.

[9] ZHANG W,ZHOU H,SUN S,et al. Robust multi⁃modality multi⁃ object tracking[C]. Proceedings of the IEEE International Confer⁃ ence on Computer Vision,2019:2365-2374.

[10] FROSSARD D,URTASUN R. End⁃to⁃end learning of multi⁃sen⁃ sor 3d tracking by detection[C]. 2018 IEEE International Confer⁃ ence on Robotics and Automation (ICRA). IEEE, 2018:635-642.

[11] 徐國豔,牛歡,郭宸陽,等. 基於(yu) 三維激光點雲(yun) 的目標識別與(yu) 跟蹤研究[J]. 汽車工程,2020,42(1):38-46. XU Guoyan,NIU Huan,GUO Chenyang,et al. Research on tar⁃ get recognition and tracking based on 3D laser point cloud[J]. Au⁃ tomotive Engineering,2020,42(1):38-46.

[12] 謝德勝,徐友春,王任棟,等. 基於(yu) 三維激光雷達的無人車障礙物檢測與(yu) 跟蹤[J]. 汽車工程,2018,40(8):952-959. XIE Desheng,XU Youchun,WANG Rendong,et al. Obstacle detection and tracking for unmanned vehicles based on 3D laser radar[J]. Automotive Engineering,2018,40(8):952-959.

[13] XIANG Y,ALAHI A,SAVARESE S. Learning to track:online multi ⁃ object tracking by decision making[C].Proceedings of the IEEE International Conference On Computer Vision,2015:4705- 4713.

[14] 婁新雨,王海,蔡英鳳,等. 采用64線激光雷達的實時道路障礙物檢測與(yu) 分類算法的研究[J]. 汽車工程,2019,41(7):779-784. LOU Xinyu,WANG Hai,CAI Yingfeng,et al. A research on an algorithm for real ⁃time detection and classification of road obsta⁃ cle by using 64⁃line lidar[J]. Automotive Engineering,2019,41 (7):779-754.

[15] SHI S,GUO C,JIANG L,et al. Pv⁃rcnn:point⁃voxel feature set abstraction for 3d object detection[C]. Proceedings of the IEEE/ CVF Conference on Computer Vision and Pattern Recognition, 2020:10529-10538.

[16] SHI S,WANG X,LI H. Pointrcnn:3D object proposal genera⁃ tion and detection from point cloud[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2019:770-779.

[17] RACHMAN A S A. 3D⁃lidar multi object tracking for autonomous driving[D]. Delft:Delft University of Technology,2017.

[18] 文龍 . 基於(yu) 車載激光雷達的無人駕駛車輛障礙物檢測與(yu) 跟蹤 技術研究[D]. 長春:吉林大學,2020. WEN Long. Research on obstacle detection and tracking technolo⁃ gy of autonomous vehicle based on lidar[D]. Changchun:Jilin University,2020.

[19] CHIU H,PRIOLETTI A,LI J,et al. Probabilistic 3D multi ⁃ob⁃ ject tracking for autonomous driving[J]. arXiv Preprint,arXiv:2001.05673,2020. [20] BERNARDIN K,STIEFELHAGEN R. evaluating multiple object tracking performance:the CLEAR MOT metrics[J]. EURASIP Journal on Image and Video Processing,2008,2008:1-10.

[21] LI Y,HUANG C,NEVATIA R. Learning to associate:hybrid⁃ boosted multi ⁃ target tracker for crowded scene[C]. 2009 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2009:2953-2960.

轉載請注明出處。

相關文章

相關文章

熱門資訊

熱門資訊

精彩導讀

精彩導讀

關注我們

關注我們