車雲按:要想在2021/2022的年度車型上實現SAE L4/L5的全自動駕駛功能,就需要應用多種傳感器冗餘係統。當今的半自動駕駛係統采用了各種各樣數量和設計的雷達和攝像頭係統。而高性能價格合理、能檢測300米半徑內信息的激光探測與測距係統開發,還處在預研階段。大多數汽車製造商都認為,如果要實現全自動駕駛,雷達,攝像頭和激光雷達這三大傳感器係統缺一不可。

本文介紹了上述幾種傳感器係統的主要特點、優劣勢和技術的發展現狀。此外還從供應商角度討論了實現智能和低成本解決方案所需的半導體元器件。本文作者Uwe Voelzke為半導體行業從業人員,車雲菌進行了全文編譯。

到底是什麽自動駕駛?

如果一輛車配備了巡航和限速功能,這算是自動駕駛嗎?當然不算,但如果加上自動距離保持和自適應巡航控製(ACC Adaptive Cruise Control)、並且司機可以在某些情況下短暫地將控製權交給車子本身呢?

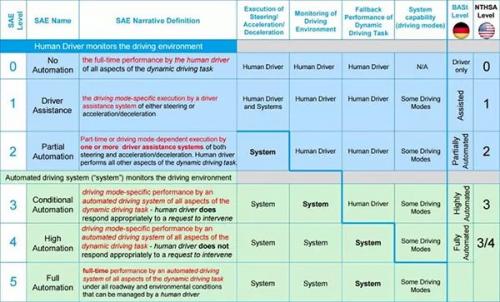

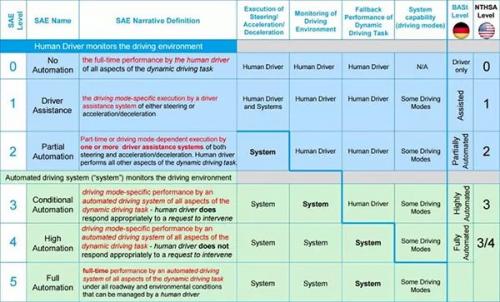

對於自動駕駛的不同類別劃分已經在以下表一中列出了。這一分類在美國是基於國際工程與汽車工業協會SAE3016標準列出的,在歐洲則是聯邦高速公路研究所製定的。具體可以參考車雲菌以往的文章(一篇文章讀懂NHTSA自動駕駛分級),這裏不做贅述。

自動駕駛分級

到目前為止,沒有汽車製造商能在量產的汽車中實現L3或更高等級的自動駕駛功能,但也有一部分已經生產出了樣車。有些國家正在製定法律,以準入一些預計2020/2021上市的SAE L3自動駕駛汽車。

要實現L1-L5自動駕駛分別需要什麽樣的傳感器?如上文所說,目前有基於攝像頭/雷達/激光雷達的三種傳感器係統。盡管停車所需的超聲波傳感器目前已被廣泛應用,但它們對自動駕駛來說沒什麽作用。攝像頭和雷達係統如今都已經配備在了自動駕駛L1和L2的汽車上,它們也是是實現更高等級自動駕駛的先決條件。

圖1:汽車中使用的不同傳感器

如今的攝像頭係統采用CMOS圖像傳感器(complementroy meta-odix sensor互補金屬氧化物半導體,一種大規模集成電路製造工藝和技術),能達到100-200萬像素的高清傳感器。單\雙目攝像頭和雷達係統融合,能為駕車人提供障礙物或者移動物體的速度、距離和外觀形狀等信息。近程(工作在24 GHz)或遠程(工作在77GHz)雷達傳感器一般裝在車身的前部和後部,用來確定車身前後的交通狀況,它們能監控從距離1厘米到數百米間的狀況。目前,激光探測係統很少被用於汽車量產中,這一技術的巨大潛能還有待繼續開發,但首先需要解決成本和滿足車規標準的問題。

攝像頭

後視和360度攝像頭

視頻影像能給人類司機提供很多駕車信息,同時也能作為輸入信息被用於高度自動駕駛汽車。後視和360度攝像頭能讓司機更好地了解車子周圍的環境狀況。如今,2D攝像頭在顯示圖像和加載更多輔助信息(如輪胎轉向角度等)方麵非常常用。高端品牌車商更開始在車上加裝帶有3D影像顯示功能的攝像頭了。

為了讓3D顯示更加真實,通常需要4-6個攝像頭聯合輸入信號。而且在“圖像拚接”過程中需要格外注意,以防損失任何圖像信息或者產生重影。

不論2D還是3D攝像頭都需要圖像傳感器有至少130dB的高動態範圍(動態範圍指一個多媒體硬盤播放器輸出圖像的最亮和最暗部分之間的相對比值)。隻有這麽高的動態範圍才能保證,即使陽光直射到鏡頭上,傳感器也能得到清晰的圖像信息。目前市場上最好的圖像傳感器動態範圍達到145dB,通過24位的接口與圖像信號處理器(ISP Image Signal Processor)相連。普通的鏡頭係統動態範圍遠遠低於這個值。

另一個關鍵品質特征則是圖像傳感器的光線強度。目前,市場上最好的傳感器信噪比(SNR Signal to Noise Ratio輸出信號同時輸出的噪聲信號的比值)能達到1比1mlx(毫勒克斯),每秒顯示幀數達到30幀。

當前,汽車後視和360度攝像頭係統通常采用中央集中架構。也就是說,一個中央控製模塊統一處理4到6個攝像頭的原始數據。而由於這種數據處理是通過軟件完成的,就對處理器提出了很高的要求。因為需要更多的FPGA(Field-Programmable Gate Array,即現場可編程門陣列,一種可編程半定製集成電路,可以更快更好地實現集成電路設計功能)來加快硬件處理的速度,在係統中造成了很高的能量損失。最新的數據壓縮方法也需要大量的存儲空間。

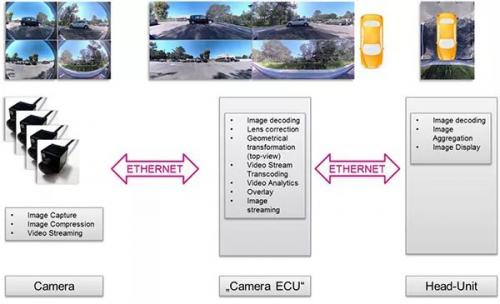

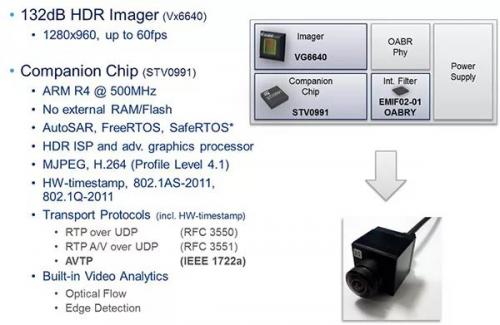

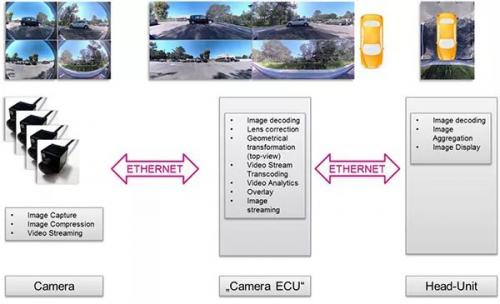

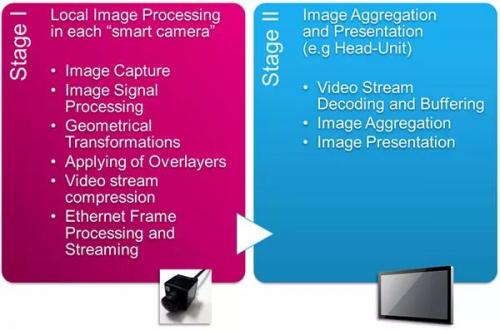

以下圖片展示了另一種方法,該方法將圖像處理過程分散在各個攝像頭上,再將處理後的數據通過Ethernet(局域以太網)傳送給汽車車機主機(包含主顯示屏控製功能的電子控製模塊),從而完成圖像的收集和顯示。單個的圖像信息在攝像頭內處理,再通過以太網接口和短延時視頻編碼器H264被送到音響主機的主處理器中。圖2展示的是未來車載攝像頭係統從模擬信號向數字信號發展的過程。

圖2:未來車載攝像頭係統從模擬信號向數字信號的發展

到2020年,大多數攝像係統都將是以數字信號為基礎的。現有的數字攝像係統將獲得的原始數據處理後送到顯示模塊進行圖像顯示。圖3則展示了這一過程。

圖3:中央集中式圖像處理

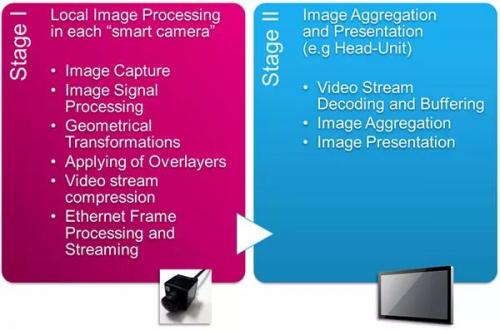

非中央集中化的方式完全去掉了攝像頭控製模塊(ECU),隻留下了智能攝像頭和車機主機。說得更直白一點,這一方法在攝像頭和中央攝像頭控製模塊中各有一個處理步驟,圖4列出了相關細節。

圖4:兩階段係統路徑

第一階段(在數碼攝像頭內部),處理圖像信息,完成在視覺效果方麵的轉換,如魚眼和濾鏡,圖像壓縮以及以太網處理和傳送也在這裏完成。第二階段(在中央攝像頭模塊裏),完成視頻解碼、中間存儲和將圖像顯示在屏幕上的過程。

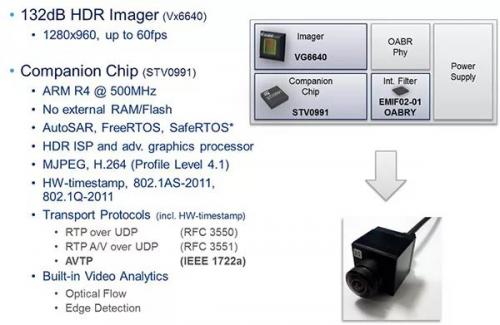

這一方法使後視攝像頭能夠壓縮信息並通過以太網傳輸到車機主機上。圖5顯示了一個此類高度集成化的數碼後視攝像頭的技術細節。

圖5:高度集成化的車用後視攝像頭

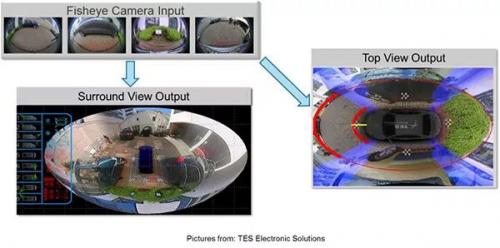

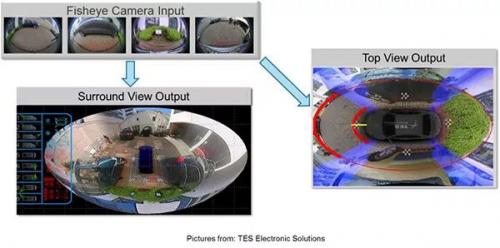

數碼攝像頭還有一種應用,是將4個攝像頭的視頻信號融合成一個360度無死角觀察視線,如圖6所示。

圖6:360環視

前視攝像頭係統

這一類係統常常用於距離中等或更遠的場合,如在90米到250米的距離上。這些攝像頭采用算法來自動檢測物體、給它們分類並判斷出距離它們的遠近。例如,攝像頭能判別行人和騎自行車的人、摩托車、路邊黃線、橋梁橋墩和馬路牙子。這類算法也被用在探測交通標識和信號上。

中程攝像頭往往會就十字路口的情況、行人、前車緊急刹車、探測到的車道和信號燈情況給司機以警告。長程攝像頭則被用於辨識交通標誌、基於視頻信息控製車距和道路導航 。

在這些攝像頭係統中,因為隻有直接來源於圖像傳感器的原始數據會被用到,所以不怎麽需要對顏色進行準確地複原。通常,係統會采用帶有RCCC矩陣(Red Clear Clear Clear, 指一個像素帶有一個紅光和三個無色濾鏡)的顏色濾鏡,從而在大多數圖像傳感器中得到比RGB(Red Green Blue, 紅綠藍)濾鏡更高的光線強度(從而圖像也才更清晰)。

中程和遠程攝像頭之間最主要的區別就是鏡頭的孔徑角度,也叫FoV(Field of View視場)。中程鏡頭的水平視界(與水平線的夾角)約為70度到120度,而孔徑角度更廣的攝像頭的水平視界通常為35度。

未來的係統會將中程和遠程圖像的內容通過光學係統集成起來,屆時,攝像頭的圖像傳感器將超過700萬像素。

雷達

有事故數據表明,超過76%的事故都是僅僅由於人類的錯誤而產生的;而在94%的事故中,有人類失誤的因素在內。ADAS(Advanced Driver Assistance Systems,高級駕駛員輔助係統)配備了數個雷達傳感器,從而能很好地支持無人駕駛的整體功能。當然,這裏還是有必要說明一下,RADAR全稱為Radio Detection And Ranging,即用無線電波探測和定位物體。

目前的雷達係統一般采用24GHz或77GHz的工作頻率。77GHz的優勢在於其對測距和測速的準確性更高,水平角度的分辨率也更好,同時天線體積更小,也更少出現信號幹擾的情況。

以下是SRR(Short-range radar短程雷達係統)和MRR/LRR (mid-range radar, long-range radar中/長程雷達係統)的主要區別。

短程雷達的主要應用方麵為:

1) 盲區探測(盲區監控)

2) 車道保持和變道輔助

3) 後置雷達碰撞報警或防撞保護

4) 泊車輔助

5) 十字路口交通監控

中長程雷達的主要應用方麵為:

1) 刹車輔助

2) 緊急製動

3) 自動距離控製

短程雷達一般被用於替代超聲波傳感器以及支持更高等級的自動駕駛。為此,汽車上每個角落都將被安上傳感器,車身前端則會裝一個用於長程探測的前視傳感器。車身360°全覆蓋的雷達係統中,車身兩側中部也會另外安裝上傳感器。

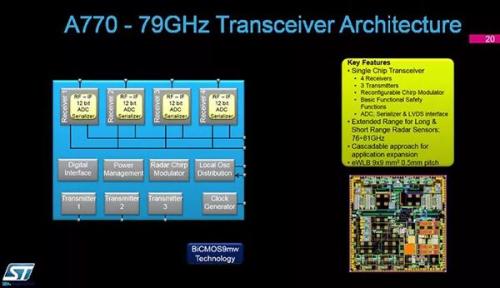

理想狀況下,這些雷達傳感器都將采用79GHz的頻段和4Ghz的傳輸帶寬。但是,全球信號頻率傳輸標準目前在77GHz頻道隻允許1GHz的帶寬。如今,對於雷達MMIC (monolithic microwave integrated circuit單塊微波集成電路)的基本定義是“3個發射頻道(TX)和4個接收頻道(RX)被集成在單塊電路上”。

行業內的討論的熱點問題在於:將基帶處理功能集成在MMIC上,或是專注於製造僅負責收集原始數據的雷達傳感器,哪一種更好。

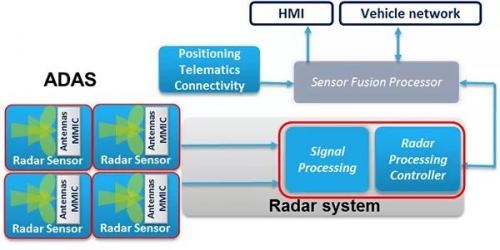

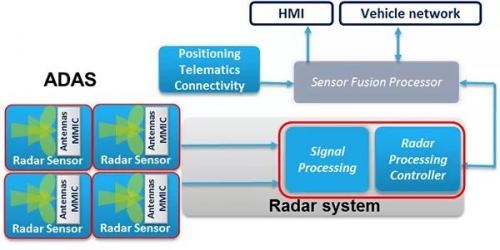

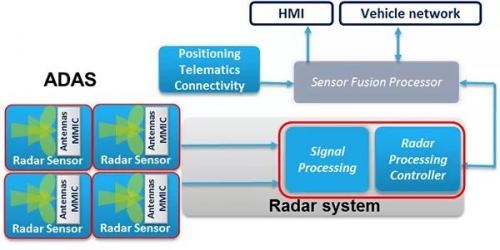

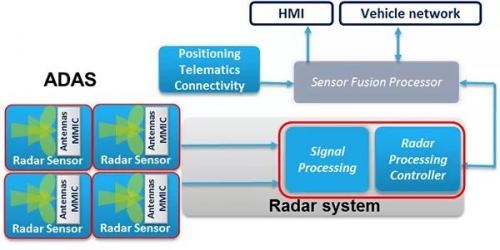

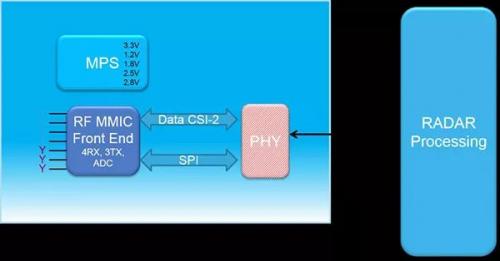

兩者的區別在於,加了基帶處理器之後,就有了“預處理數據”,也就是說,有關每個探測對象的速度、距離、信號強度、水平角和垂直角等未被最終驗證的信息都在傳感器上先預處理過了。反之,僅負責數據收集的雷達傳感器則隻會提供未經篩選的原始數據,然後傳給ECU來處理。圖7展示了僅進行原始數據收集的雷達傳感器的基本架構。

圖7:雷達傳感器(僅進行原始數據收集)的基本架構

在雷達傳感器不進行預處理的情況下,基帶處理功能被集成在了雷達處理控製器裏,而雷達傳感器會將未經處理的數據直接傳輸給處理控製器。

這一方法有幾大優點。首先,將基帶處理功能集成化,就能采用一個相對簡單的COMS線性結構,而不是射頻設備獨有的優化技術,這樣就能節約所需的單晶矽表麵麵積,從而降低成本。還有一個優勢是將需要散熱的位置從雷達係統轉移到了控製單元中,由於控製器比雷達傳感器的空間更大,從而能更好地解決散熱問題。

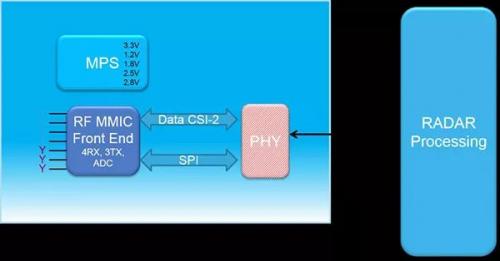

最後,因為不對數據進行過濾或壓縮,也就不會產生數據丟失,控製器能夠直接使用來自於傳感器的原始數據,從而使信號處理有更多和更靈活的方法。就算這樣的情況下對傳感器的傳輸速率有了更高的要求,這也不是問題,因為數據可以通過MIPI CSI-2通信協議接口傳輸(見圖8)。

圖8:MIPI CSI-2通信協議接口

這一接口協議如今已經被商業化,如用在視頻環視係統中。這種架構與圖8中的原始數據雷達傳感器配合地非常好:信號接口有4條數據線,可以接入4個信號接收器,並配有12位的雷達單塊微波集成電路,通信接口的帶寬也能達到1到1.5Gbit每秒。

如圖9所示,因為這樣的雷達傳感器布置采用了相同的通信接口,這就簡化了攝像頭和雷達以及未來的激光傳感器(收集到的)數據的融合過程。

MMIC的技術發展有個先決條件,即通過高頻技術來實現24GHz或77GHz的頻帶要求並滿足其相應的輸出功率。

如今,鍺矽異質結雙極晶體管已經被用在高頻部件上,而單片130納米CMOS處理器也已經被用於邏輯集成電路。過去的數年裏,ST(意法半導體公司,全球最大的半導體生產研發公司之一)已經利用BiCMOS技術生產出了24GHz的單塊微波集成電路,。而77/79GHz基帶技術的發展也采用了最新的BiMOS9MW技術,CMOS元件的寬度可以達到最小130nm。

針對未來的超高頻122GHz頻帶雷達係統,ST也已經開發出了B55技術。這一技術使鍺矽異質結雙極晶體管能達到超過320GHz的傳輸頻率,而且還可以被集成在55納米的CMOS數字邏輯電路上。

除了優化的BiCMOS技術,意法半導體公司還能將片上係統通過公司自行開發的FD-SOI技術集成起來,刷製在僅有28nm厚的電路板上。圖9顯示了目前MMIC的發展過程。在24GHz頻帶範圍內的最新研發成果是A431塊,它包含了一個發射器和三個接收器。圖中的26GHz基帶元件則主要是為美國市場而開發的。

▲圖9:MMIC路線圖

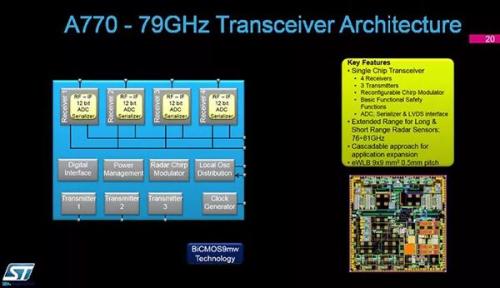

路線圖展示的77/79GHz零件中,A770/A772目前還處於研發階段,而圖10框圖中的A770MMIC收發器已經是一個高度集成的產品了。

圖10:A770MMIC收發器

A770是一個單片集成收發器,包括了三個發射器、四個接收器、一個可調的鋸齒波發生器,一個集成的ADC(Analog to Digital Converter模數轉換器)和一個MIPI CSI II 接口。當需要更多發射和接收通道時,這一模塊甚至可以被級聯起來。模塊被封裝在9mm*9mm的陶瓷EWLB(Embedded Wafer Level Ball Grid Array內嵌式晶圓級球柵陣列)中,可以被用於中程和長程探測。

目前在進行可行性研究的雷達傳感器是一個單片片上係統,同時集成了雷達和基帶傳輸功能。如同之前所說的,目前意法半導體正在研究極高的集成狀態下原始數據雷達傳感器的各個細節和可能存在的缺陷,也在通過市場方麵的研究探討其商業上的相關問題。

激光雷達傳感器

激光雷達是汽車領域相對較新的應用係統,但正愈來愈引起人們的注意。係統和半導體供應商們正專注於研發和改進新的解決方案,並計劃2020/2021年將樣件應用起來。

什麽是LIDAR(激光雷達)?如前所說,它是利用激光進行探測和測距技術的簡稱。除了需要激光發射器,這一係統還需要有一個高精度的接收器。由於能通過獨特的方法提供被探測物體的三維影像,激光雷達主要被用於測量與固定或移動物體間的距離。

如今,任何買了激光測距儀的人都在用這種方法在家中、建築材料商店等地方測量距離,其能測量的距離可達數米。而對於駕駛員輔助係統,關鍵挑戰則在於保證係統在任何環境狀況下(溫度變化、陽光照射、黑暗中或雨雪天氣)都能正常工作,而且還要能辨認出300米以外的物體。當然,還需要能夠體積最小,可以在最低的成本下大規模生產。

激光雷達係統不是新興事物,也已經在工業和軍事方麵應用了很多年。但是,我們這裏所說的是複雜的機械透鏡係統,還要帶有360度無死角視線,能捕捉到物體的空間三維影像。如果還像工業和軍事上那樣售價成千上萬美元,那麽將不可能被大規模運用在汽車領域。

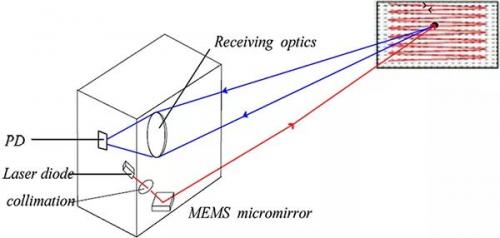

如今,激光雷達係統有2個主要發展方向,紅外激光雷達係統加上微電機械係統(MEMS Micro-Electro-Mechanical System)(配上轉動的激光發射器),或者采用固定狀態的激光雷達係統。

在簡要地討論這些技術的區別以前,需要對接收係統解釋一下。

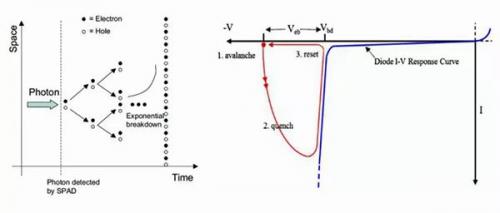

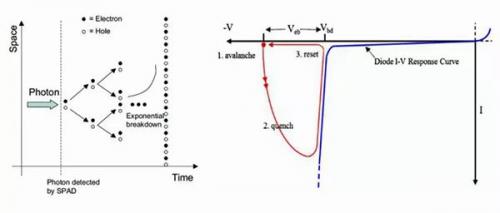

接收係統的主要功能是識別從發射器發出的和從物體上反射的光束。因此探測器需要非常靈敏,以至能夠探測到單個的光子。如今,最新的相關設備采用了SPAD(Single-Photon Avalanche Diode單光子雪崩二極管) 技術。

▲圖11:SPAD 傳感器單元的原理

該技術的原理很簡單,如圖11所示。這個二極管有特殊的偏移PN結結構,所以單個的光子就能在二極管內造成雪崩電流(由一點小電流引發的大量電流,類似雪崩現象,故名)。快速增大的二極管電流會被相應的電路探測到,然後產生數字信號,用於後期處理。

▲圖12:激光雷達測距原理

圖12顯示的是采用SPAD傳感器測量距離的工作原理。在時間為X時,激光發射器發出一個脈衝光信號,這一信號會被物體反射回來,經過Y時間後一個(或更多)光子到達傳感器,到該物體間的距離可以從光線傳播的時間長短計算出來。

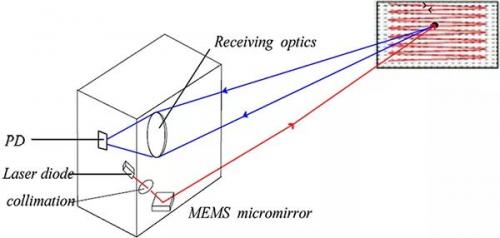

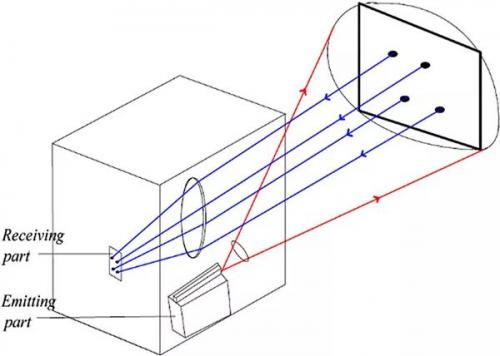

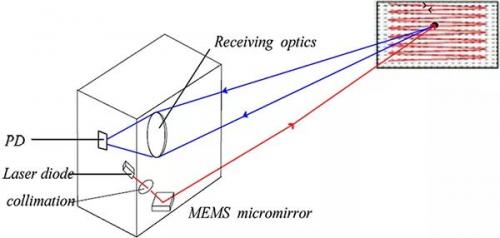

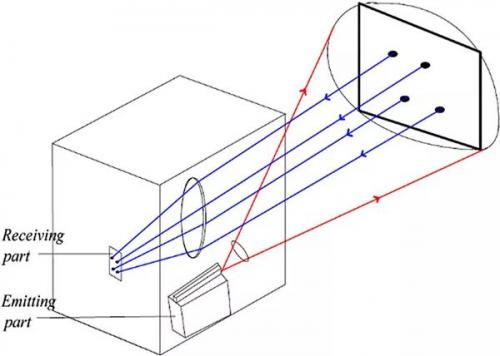

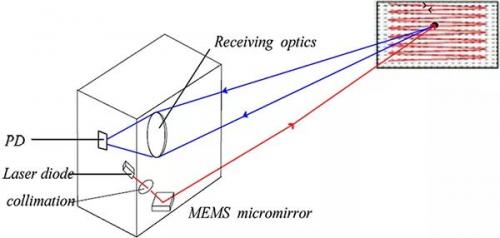

如果一束或多束光線從轉動的鏡麵或微型機械係統中發射出來,而又有一個由數個傳感器元件組成的陣列,那麽三維立體的物體也能被探測出來。圖13和14就展示了兩種基本的激光探測係統的測量過程。

▲圖13:固態激光雷達測距原理

▲圖14:基於MEMS的激光雷達測距原理

當采用基於MEMS技術的微型鏡麵係統時,單一束的激光信號會以線形形式被發散和反射回來,反射的光子被相對應的SPAD元件中的光敏傳感器檢測到。這對於鏡麵係統準確性、工作壽命、可調節度和可靠性有非常高的要求。畢竟這是一個內部帶有可動部件的係統。

乍一看上去,一個沒有可動零件的係統似乎更容易實現。但在這一係統中,需要數個(超過100個)激光二極管以及一個相對較大的接收器陣列。激光二極管必須能發出脈衝寬度在毫微秒級上的、電流達數個安培的信號能力,這對半導體製造商是很大的挑戰。

兩種係統都還在開發中。從一個半導體製造商的角度上來看,係統所需的半導體元件在技術上是可行的,但是SPAD陣列所需的空間麵積不好實現。要想激活和控製激光二極管陣列,並實現大約100美元的目標成本,則需要新的方法。相應的微電機械係統也正在研發當中。

總結與展望

能保證L3及其以上無人駕駛功能的駕駛員輔助係統,至少需要三種傳感器係統:攝像頭、雷達和激光探測。每種傳感器都應當有好幾個,分布在汽車的不同位置上,共同工作。盡管如今已經有了所需的半導體技術和攝像頭及雷達傳感器開發技術,但激光雷達係統的發展情況在技術和商業問題上仍然是當前最大和最不穩定的挑戰。

很難說我們討論的哪一種係統會流行起來,但從半導體的角度,固態激光雷達係統的方法看起來似乎是最好的。

![]()

![]()

相關文章

相關文章 網友點評

網友點評

熱門資訊

熱門資訊 精彩導讀

精彩導讀 關注我們

關注我們